Aplicación de pruebas lingüísticas en la formación universitaria. Evaluación de un proceso formativo

Aplicação de testes linguísticos na formação universitária. Avaliação de um processo formativo

Application of language tests in university education. Evaluation of a formative process

Alba Ayuso-Lanchares 1  https://orcid.org/0000-0002-0740-7212

https://orcid.org/0000-0002-0740-7212

Inés Ruiz-Requies 1  https://orcid.org/0000-0001-5785-1795

https://orcid.org/0000-0001-5785-1795

Rosa Belén Santiago-Pardo 1  https://orcid.org/0000-0002-3317-503X

https://orcid.org/0000-0002-3317-503X

1 Universidad de Valladolid (UVa), España

Resumen. La aplicación de pruebas lingüísticas en contextos reales es una competencia fundamental que los estudiantes de los grados en Logopedia y en Educación Primaria deben aprender. El objetivo de esta investigación consiste en comprender y evaluar el proyecto formativo universitario llevado a cabo para que los estudiantes aprendan a aplicar pruebas lingüísticas. El proyecto se divide en tres fases: los estudiantes graban la aplicación de las pruebas lingüísticas, los profesores enseñan el proceso de evaluación, y otros estudiantes analizan y corrigen las pruebas grabadas. Un grupo de 200 participantes completa un cuestionario que incluye preguntas sobre las dificultades y desafíos encontrados y la idoneidad de la práctica. Se valora por separado la enseñanza de pruebas estandarizadas/baterías y la enseñanza de protocolos/registros. Los resultados sugieren que las actividades propuestas son apropiadas. Aunque no se observan diferencias significativas entre los grupos en cuatro variables, surgen disparidades en la comprensión de los vídeos, la toma de notas en las hojas de registro, la elaboración de conclusiones y la redacción de informes. Lo que significa que esta investigación es útil para aquellos docentes que estén interesados en llevar a cabo proyectos formativos con aplicación práctica en el aula y poder así generalizar el proceso formativo a otras universidades.

Palabras clave: evaluación; docencia; lenguaje; formación.

Resumo. A aplicação de testes linguísticos em contextos reais é uma competência fundamental que os estudantes de graduação em Logopedia e em Educação Primária devem aprender. O objetivo deste estudo consiste em compreender e avaliar o projeto formativo universitário realizado para que os estudantes aprendam a aplicar testes linguísticos. O projeto é dividido em três fases: os alunos gravam a aplicação dos testes linguísticos, os professores ensinam o processo de avaliação e outros estudantes analisam e corrigem os testes gravados. Um grupo de 200 participantes preenche um questionário com perguntas sobre as dificuldades e desafios encontrados e a idoneidade da prática. Pontua-se separadamente o ensino de testes padronizados/baterias e o ensino de protocolos/registros. Os resultados sugerem que as atividades propostas são apropriadas. Embora não se observem diferenças importantes entre os grupos em quatro variáveis, surgem disparidades na compreensão dos vídeos, na anotação das horas de registro, na elaboração de conclusões e na redação de relatórios. Tudo isso significa que este estudo é útil para aqueles professores que estão interessados em desenvolver projetos formativos com aplicação prática na aula e poder assim levar esse processo formativo também para outras universidades

Palavras-chave: avaliação; docência; linguagem; formação

Abstract. The application of linguistic tests in real contexts is a fundamental competency that students in Speech Therapy and Primary Education degrees must learn. The aim of this research is to understand and evaluate the university training project carried out to teach students how to apply linguistic tests. The project is divided into three phases: students record the application of linguistic tests, teachers teach the evaluation process, and other students analyze and correct the recorded tests. A group of 200 participants completes a questionnaire that includes questions about the difficulties and challenges encountered and the suitability of the practice. Teaching of standardized test/battery and teaching of protocols/records are separately evaluated. The results suggest that the proposed activities are appropriate. Although no significant differences are observed between the groups in four variables, disparities arise in understanding the videos, taking notes on the record sheets, drawing conclusions, and writing reports. This indicates that this research is useful for educators interested in conducting training projects with practical application in the classroom and thus being able to generalize the training process to other universities.

Keywords: assessment; teaching; language; training

1. Introducción

Los entornos educativos deben mantener los principios de normalización, inclusión y no discriminación, con profesores especializados y recursos para el alumnado con necesidades educativas especiales (Law et al., 2019). Las familias y los maestros son los primeros en darse cuenta de las dificultades de los niños y niñas con dificultades de lenguaje y comunicación; sin embargo, todos los miembros de la comunidad educativa deben sentirse responsables de atender a la diversidad y se les debe formar en este aspecto (García-Gómez et al., 2022).

En España, contamos con dos profesionales competentes en la intervención lingüística, los logopedas y los maestros de audición y lenguaje. Según la legislación vigente, el maestro de audición y lenguaje promueve la prevención y el desarrollo de capacidades comunicativo-lingüísticas, mientras que los logopedas trabajan aspectos más amplios y técnicos, realizando tareas de prevención, evaluación y recuperación de trastornos del lenguaje y la comunicación (Ley 44/2003, de 21 de noviembre). Ambos profesionales deben saber planificar la evaluación-intervención utilizando instrumentos y técnicas específicas (Cifuentes-Lardín y Martínez-Ramón, 2018; Real Decreto 861/2010 de 2 de julio). En el caso de los maestros de audición y lenguaje, estas intervenciones se realizan con alumnado con necesidades específicas de apoyo (Ley Orgánica 3/2020 de 3 de mayo), mientras que en logopedia se interviene con todo sujeto susceptible de tener alguna alteración en la comunicación, en el lenguaje, en el habla, en la voz, en la audición y/o en la deglución. En los planes de estudio de estos grados se plantea que deben saber planificar la evaluación-intervención y aplicar los instrumentos y técnicas de los trastornos del desarrollo del lenguaje. Sin embargo, es difícil que los estudiantes de estas titulaciones dispongan de suficientes casos reales para aprender los procesos de intervención, por lo que se considera imprescindible realizar una propuesta que facilite esta competencia realizando prácticas en la formación universitaria (Nieva et al., 2015). Por todo ello, es necesario realizar proyectos formativos para mejorar el aprendizaje de los estudiantes universitarios de estas pruebas de evaluación lingüística. Además, con el objetivo de mejorar la evaluación que van a realizar estos futuros profesionales (Reeves y Honig, 2015), es fundamental recoger de manera sistemática y organizada las intervenciones que los estudiantes universitarios llevan a cabo.

1.1 Pruebas de evaluación lingüística

Cohen (2001) explica los principios o requisitos que guían el proceso de evaluación en los niños y niñas con dificultades del lenguaje. Algunos de estos requisitos son: que el evaluador tenga un extenso conocimiento del desarrollo y el procesamiento del lenguaje; que la información se recoja en diferentes ámbitos y contextos de manera longitudinal y desde diferentes perspectivas: psicopedagógica, educativa y sociofamiliar; y, por supuesto, conocer las diferentes estrategias e instrumentos de evaluación: entrevistas, test estandarizados, cuestionarios, observaciones, etc. Según Wirz (1993), existen dos métodos para evaluar, descriptivos y prescriptivos. Los prescriptivos se basan en el razonamiento inductivo y plasman la conducta del niño para poder tomar la decisión de dónde se halla el problema. En cambio, los métodos descriptivos son deductivos e incluyen los test estandarizados, ampliamente utilizados para diagnosticar dificultades del lenguaje oral (Mendoza, 2010).

Tirapu-Ustárroz (2007) explica que existen tres tipos de pruebas de evaluación neuropsicológica formal: escalas breves; baterías neuropsicológicas general o test específicos. Las escalas breves son test de fácil y corta aplicación, que constan de un conjunto de preguntas variadas. Las baterías generales de evaluación son un conjunto de pruebas o elementos que exploran las principales funciones cognitivas. Finalmente, las pruebas específicas utilizadas para realizar una evaluación individualizada y más profunda de algún área o dimensión.

Otros autores como Ayuso-Lanchares et al. (2022) y Tirapu-Ustárroz (2007), hablan de los métodos descriptivos donde se incluye una evaluación más formal, como son:

• Pruebas estandarizadas: es común y obligatorio utilizar estas pruebas para lograr un correcto diagnóstico de ciertas dificultades o trastornos, como puede ser el trastorno del desarrollo del lenguaje (Carballo, 2012). Un ejemplo de pruebas que se utilizan en esta investigación son el: PLON-R (Aguinaga et al., 2004); Peabody Picture Vocabulary Test (Dunn et al., 2006); TSA (Aguado, 1989), entre otros.

• Baterías: son un conjunto de test, pruebas o elementos que exploran las principales funciones cognitivas. Un ejemplo de batería que se utiliza en esta investigación es la Batería Neurobel (Adrián et al., 2015).

• Protocolo de evaluación: que sistematiza la evaluación que se debe llevar a cabo, siguiendo unas pautas marcadas, y su evaluación puede ser o no cuantitativa. Un ejemplo de protocolo que se utiliza en esta investigación es el Protocolo Rápido de evaluación pragmática Revisado (PREP-R) (Fernández-Urquiza et al., 2015).

• Registro de evaluación: es un instrumento de evaluación que permite obtener información sobre el habla y/o lenguaje espontáneo del alumno. Un ejemplo de registro que se va a utilizar en esta investigación es el Registro Fonológico Inducido (RFI) (Juárez y Monfort, 1996).

1.2Proyectos formativos universitarios

No cabe duda de que, en los últimos años, se ha incrementado la importancia de la evaluación del proceso de enseñanza-aprendizaje para mejorar la calidad docente (Morales-Ocaña e Higueras-Rodríguez, 2017). De esta manera, uno de los factores que está asociado al éxito del aprendizaje en los estudios universitarios es el de la planificación de proyectos formativos y profesionales (Álvarez-Pérez et al., ٢٠١٥). Además, también existe evidencia de la relación directa existente entre la satisfacción con la enseñanza que los estudiantes reciben y el éxito académico (Guzmán, 2011). Por ello, se considera fundamental conocer en profundidad la percepción de los estudiantes universitarios que han participado en proyectos formativos con casos reales, como es la investigación que se presenta en este artículo.

En la actualidad, existen muy pocas evaluaciones de programas formativos dentro del Grado en Logopedia. Uno de los pocos, es el de Peñalba-Acítores et al. (2014) en el que evaluaron la participación de estudiantes en un programa intensivo internacional de logopedia de una semana de duración; otro es el de Calleja-Reina et al. (2019) que se centró en describir una herramienta b-learning diseñada para entrenar las competencias en la toma de decisiones para el diagnóstico clínico en estudiantes del Grado en Logopedia; y otro el de Nieva et al. (2015) que describe la utilización de una base de datos audiovisual con estudiantes del Grado en Logopedia.

Ciertamente, el número de proyectos formativos que incluyen estudiantes del Grado en Educación Primaria en la mención de Audición y Lenguaje es algo mayor. Se encuentran proyectos formativos, como el de Modrego-Alarcón et al. (2022), que pretende acercar la realidad educativa al estudiantado universitario de esta mención a través de un seminario permanente entre el profesorado universitario y el profesorado de los centros educativos, y de esta manera crear una red amplia de intercambio formativo. Además, encontramos otros proyectos más amplios que incluyen a todos los estudiantes del Grado en Educación Primaria, independientemente de la mención. Por ejemplo, la investigación de Raposo-Rivas et al. (2006), que persigue conocer cómo es el desarrollo de las competencias tecnológicas en la formación de los maestros; o el artículo de Sevillano-García y Fuero-Colmena (2013), que describe la opinión de los estudiantes del Grado en Educación (entre los que se encuentran 141 estudiantes de Audición y Lenguaje); sobre las TIC. En la literatura, no se ha encontrado la evaluación de proyectos formativos universitarios que incluyan a estudiantes de ambos grados, como es el caso de esta investigación. Y tampoco se han encontrado proyectos formativos que pretendan enseñar a los estudiantes a corregir, evaluar e interpretar pruebas de evaluación del lenguaje oral, como es el caso de este trabajo.

Por estos motivos, este proyecto formativo consiste en el aprendizaje de la aplicación y corrección de diferentes pruebas de lenguaje oral, a través del visionado de vídeos donde se observa la aplicación de una determinada prueba en un caso concreto y donde el estudiante, visto el vídeo, debe recoger datos y corregir la prueba que le corresponda; tarea que es de gran utilidad para valorar si la tarea es apta para el aprendizaje. Además, se pretende hacer énfasis en el problema fundamental que supone la falta de oportunidades prácticas y experiencias con casos reales durante la formación académica de los estudiantes universitarios. Repercutiendo, así, de manera negativa a la adquisición de habilidades y competencias relacionadas con la evaluación, corrección e interpretación de pruebas de evaluación del lenguaje oral. En consecuencia, y conocida dicha necesidad, se ha diseñado este proyecto formativo universitario que permite a los estudiantes desarrollar y adquirir estas competencias académicas y profesionales tan necesarias en su futuro laboral. Es por ello, por lo que las preguntas de investigación que guía este estudio son ¿cuál es la percepción de los estudiantes sobre este proyecto formativo universitario? ¿le sirve para adquirir competencias de evaluación, corrección e interpretación de pruebas de evaluación del lenguaje oral?

Así pues, esta investigación pretende dar respuesta a dichas cuestiones y comprender en profundidad el proyecto formativo llevado a cabo. Se persigue evaluar dicho proyecto desde la satisfacción como desde las dificultades encontradas por los estudiantes de los grados en Logopedia, Maestro en Educación Primaria Generalista, y Maestro en Educación Primaria, mención Audición y Lenguaje. No cabe duda de que la evaluación realizada será de gran utilidad para poder generalizar el proceso formativo a otras universidades.

Dada la naturaleza de la investigación y sus objetivos, el enfoque de investigación utilizado es mixto (Creswell, 2014), combinando fuentes de datos cuantitativas y cualitativas producidas simultáneamente para para obtener una comprensión integral del fenómeno estudiado (Schoch, 2020), también denominado modelo mixto de triangulación según Greene (2007). Este enfoque mixto permite no solo describir y explicar una práctica formativa real, sino también evaluar su utilidad para el aprendizaje.

El diseño de investigación que se lleva a cabo es un estudio de caso evaluativo (Pérez-Serrano, 1994; Simons, 2011) que se adapta con el modelo mixto de triangulación elegido (Guetterman y Fetters, 2018). El estudio de caso se diseñó específicamente para analizar en profundidad una situación concreta de formación universitaria en la aplicación y corrección de pruebas de evaluación del lenguaje oral. La elección de este enfoque metodológico facilitó la obtención de datos de manera detallada y contextualizada, permitiendo una evaluación exhaustiva de la práctica formativa en cuestión.

2.1 Descripción del proyecto formativo

El proyecto formativo se ejecuta durante los meses de septiembre a junio, en las asignaturas del Grado en Logopedia: Bases pedagógicas de intervención logopédica; Evaluación y diagnóstico del lenguaje; Intervención logopédica en discapacidad intelectual, disartrias y parálisis cerebral; Intervención logopédica en TDL y afasias adquiridas; Intervención logopédica en tercera edad y en el Practicum III. Y en el Grado en Educación Primaria en las asignaturas de Psicología del desarrollo; Evaluación e intervención en los trastornos del lenguaje y SAC y en el Practicum II.

Este proyecto se articula en tres fases en todas las asignaturas:

• Una primera fase en la que estudiantes de 4.º graban el audio y/o vídeo del proceso de aplicación de la prueba, con un caso real dentro de la asignatura Practicum. Esta acción es supervisada por su tutor/a de prácticas del centro educativo o gabinete. Los vídeos se editan y se ponen a disposición de los profesores de las respectivas asignaturas, citadas anteriormente, para poder llevar a cabo las actividades de la segunda fase.

• En una segunda fase, los profesores de todas las asignaturas participantes explican el proceso de aplicación de la prueba correspondiente y cómo se interpretan los resultados. Después, muestran a los estudiantes el vídeo que se ha grabado en la primera fase. Las pruebas, registros o test utilizados y la cantidad de estudiantes que manejaron cada una de las pruebas se observan en la Tabla 1.

• Una tercera y última fase en la que los estudiantes, divididos en grupos de cuatro o cinco personas, observan las grabaciones de vídeo correspondientes a las pruebas, escalas o registros estandarizados aplicados a casos reales (Tabla 1). Cada grupo de estudiantes corrige una prueba diferente y registra los resultados de las pruebas que visiona en sus respectivas hojas de registro. Posteriormente, los estudiantes redactan un informe de evaluación explicando los resultados obtenidos en las pruebas, además de las conclusiones obtenidas, que puedan ayudar a un posible diagnóstico.

2.2 Participantes

En esta investigación se utiliza un muestreo no probabilístico e intencional. En el estudio participaron 200 estudiantes; un 57.5% pertenecientes al Grado en Logopedia; y un 42.5% al Grado de Maestro en Educación Primaria mención de Audición y Lenguaje y Generalista. Un 16.5% acuden al primer curso; un 19% al segundo curso, un 43% al tercer curso y un 21.5% al cuarto curso.

2.3 Instrumento de recolección de datos

Se emplea un cuestionario diseñado ad hoc a través de Microsoft Forms. Es contestado de manera anónima, para cumplir con los criterios éticos de confidencialidad y anonimato (Flick, 2018). El cuestionario incluye preguntas abiertas con la finalidad de conocer en profundidad su opinión, y cerradas de tipo Likert (1-5; siendo 1 ninguna y 5 mucha), divididas en 11 ítems distribuidos en tres dimensiones:

• Preguntas sociodemográficas: preguntas relacionadas con el grado y el curso en el que se encuentran.

• Un bloque de seis preguntas tipo Likert (1-5; siendo 1 ninguna y 5 mucha), sobre las dificultades encontradas: dificultad para escuchar/entender lo que se decía en el vídeo; dificultad para observar de manera visual los resultados que se tenían que obtener; dificultad para escribir en la hoja de registro los resultados ofrecidos; dificultad para obtener la baremación; dificultad para obtener unas conclusiones de la prueba/protocolo/registro; y, por último, dificultad para escribir el informe basándome en los resultados de la prueba.

• Un bloque de nueve preguntas tipo Likert (1-5; siendo 1 nada y 5 mucho), sobre la adecuación de la práctica: esta práctica es adecuada para esta asignatura, los conocimientos que poseía eran suficientes para realizar esta práctica; me he sentido cómodo/a con la práctica; esta prueba/protocolo/registro es difícil de aplicar; la labor del profesor ha sido de gran ayuda para realizar esta actividad; considero que aplicaré esta prueba en mi futuro laboral; considero que esta práctica ha sido de ayuda para mi aprendizaje; considero necesaria la existencia de una guía de evaluación que me ayude a conocer los procesos de evaluación; y por último, me han explicado previamente cómo se corregía la prueba y lo he entendido con claridad.

• También se incluyen tres preguntas abiertas: en caso de tener dificultad para corregir la prueba, ¿por qué ha sido así?; ¿hubieses cambiado algo de la práctica? En caso afirmativo, ¿qué hubieras cambiado? Y, por último, ¿tienes alguna observación que realizar?

La fiabilidad del cuestionario se comprueba con alfa de Cronbach que precisamente se utiliza para determinar la precisión de su medición (Amirrudin et al., 2021). El cuestionario ha obtenido una fiabilidad buena ya que el resultado ha sido de entre 0,682 y 0,718 para todas las variables (Cicchetti y Sparrow, 1981).

Por otro lado, también se utilizan las diferentes pruebas de evaluación del lenguaje oral que se pueden observar en la Tabla 1.

Tabla 1. Distribución de estudiantes que han realizado cada una de las pruebas y tipos de pruebas.

|

Tipo de prueba |

Test, registro o prueba |

Frecuencia |

% |

|

Pruebas estandarizadas y baterías (106 estudiantes- un 53% del total) |

PLON-R (Aguinaga et al., 2004) |

8 |

4.0 |

|

Peabody Picture Vocabulary Test, TVIP (Dunn et al., 2006) |

4 |

2.0 |

|

|

TSA, El Desarrollo de la Morfosintaxis en el niño (Aguado, 1989) |

25 |

12.5 |

|

|

Test Illinois de aptitudes psicolingüísticas ITPA (Kirk et al., 2004) |

13 |

6.5 |

|

|

Test de Comprensión de Estructuras Gramaticales (CEG) (Mendoza et al., 2005) |

31 |

15.5 |

|

|

La batería NEUROBEL (Adrián et al., 2015) |

25 |

12.5 |

|

|

Protocolos y registros (94 estudiantes - un 47% del total) |

Registro Fonológico Inducido (RFI) (Juárez y Monfort, 1996) |

33 |

16.5 |

|

Prueba de Articulación de Fonemas (PAF) (Vallés, 1990) |

8 |

4.0 |

|

|

Protocolo Rápido de evaluación pragmática Revisado (PREP-R) (Fernández-Urquiza et al., 2015) |

35 |

17.5 |

|

|

Prueba de evaluación fonológica de Laura Bosch (Bosch, 1983) |

18 |

9.0 |

Fuente: elaboración propia.

2.4 Procedimiento de recolección y de análisis de datos

En este apartado se presentan los datos cuantitativos y cualitativos obtenidos del cuestionario para evaluar el proyecto formativo desarrollado. Todas las respuestas de los participantes se recogieron y procesaron con el paquete estadístico SPSS 27.0 para Windows. En todas las pruebas se estableció un nivel de confianza del 95% y se establecieron frecuencias, medias y porcentajes según cada variable.

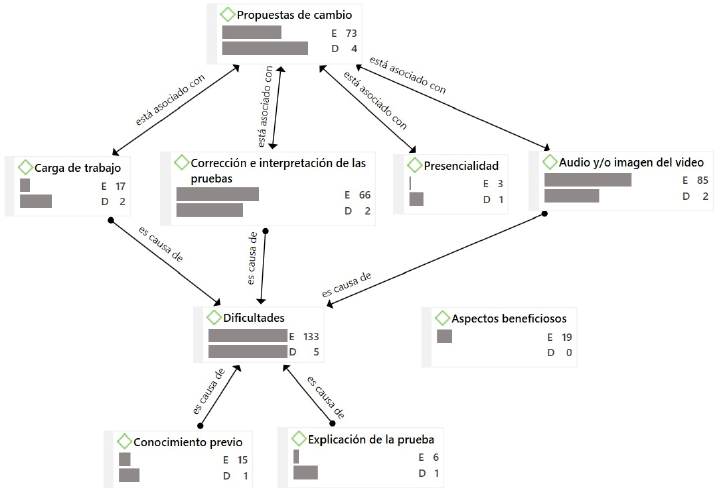

Para valorar si existe una relación entre el tipo de prueba utilizada y los resultados encontrados se establecen dos grupos, teniendo en cuenta las pruebas que han evaluado: pruebas estandarizadas y baterías (106 estudiantes, un 53% del total); y protocolos y registros (94 estudiantes, un 47% del total). Para ello, se aplica la prueba de normalidad Kolmogorov-Smirnov que indica que la muestra no tiene una distribución normal, por lo que entonces se utiliza la prueba no paramétrica U Mann-Whitney. Además de los estadísticos descriptivos, las pruebas realizadas fueron Kolmogorov-Smirnov, para valorar si se deben realizar estadísticos paramétricos o no paramétricos; y también la prueba U de Mann-Whitney, para conocer si existe una diferencia significativa entre los resultados de ambos grupos. Para finalizar, se realiza el análisis cualitativo que permite Atlas.ti 22 para Windows y se diseñan los siguientes códigos o categorías de análisis:

• Dificultades: se emplea este código cuando los estudiantes explican los problemas que se han encontrado al realizar este proyecto formativo.

• Propuestas de cambio: los estudiantes realizan sugerencias de mejora.

• Audio y/o imagen del vídeo: los estudiantes se refieren a las grabaciones realizadas por los estudiantes de 4º curso y que ellos han observado para realizar sus actividades.

• Corrección e interpretación de las pruebas: los estudiantes comentan alguna situación relacionada con el proceso de analizar los resultados de la prueba.

• Conocimiento previo: los estudiantes se refieren a los conocimientos anteriores que habían adquirido relacionados con las actividades a realizar.

• Explicación de la prueba: los estudiantes se refieren a las aclaraciones realizadas en el aula por el profesor y la manera en la que se ha descrito la prueba.

• Carga de trabajo: los estudiantes comentan sobre la cantidad de tiempo y/o esfuerzo invertido para realizar las actividades.

• Aspectos beneficiosos: los estudiantes señalan las características positivas del programa que han sido provechosas para su formación.

• Presencialidad: los estudiantes explican si es mejor realizar ellos mismos la aplicación de manera presencial, en vez de observar la grabación de un vídeo de un compañero aplicando esta prueba.

3. Resultados

En la Tabla 2 se muestran los resultados descriptivos de las preguntas tipo Likert, correspondientes a la dimensión de dificultades encontradas y a la dimensión adecuación de la práctica.

Tabla 2. Estadísticos descriptivos de las preguntas tipo Likert (1-5)

|

Test, registro o prueba |

De toda la muestra |

Grupo que aplicó pruebas estandarizas y baterías |

Grupo que aplicó protocolos y registros |

|||

|

Media |

Desviación |

Media |

Desviación |

Media |

Desviación |

|

|

Dificultad para escuchar/entender lo que se decía en el vídeo |

2.72 |

1.017 |

2.38 |

.930 |

3.12 |

.971 |

|

Dificultad para observar de manera visual los resultados que se tenían que obtener |

2.61 |

1.151 |

2.61 |

1.176 |

2.61 |

1.128 |

|

Dificultad para escribir en la hoja de registro los resultados ofrecidos |

2.05 |

.965 |

1.77 |

.843 |

2.36 |

1.004 |

|

Dificultad para obtener la baremación. |

2.00 |

1.087 |

1.74 |

.939 |

2.31 |

1.164 |

|

Dificultad para obtener unas conclusiones de la prueba/protocolo/registro que nos aporte información de los problemas de los participantes |

2.41 |

.984 |

2.22 |

.966 |

2.64 |

.960 |

|

Dificultad para escribir el informe basándome en los resultados de la prueba |

2.34 |

1.045 |

2.12 |

.966 |

2.60 |

1.040 |

|

Esta práctica es adecuada en esta asignatura |

4.53 |

.708 |

4.63 |

.607 |

4.41 |

.795 |

|

Los conocimientos que poseía eran suficientes para realizar esta práctica |

3.61 |

.991 |

3.86 |

.888 |

3.33 |

1.031 |

|

Me he sentido cómodo/a con la práctica |

3.86 |

1.077 |

4.39 |

.763 |

3.26 |

1.067 |

|

Esta prueba/protocolo/registro es difícil de aplicar |

2.40 |

1.135 |

2.24 |

1.159 |

2.60 |

1.081 |

|

La labor del profesor ha sido de gran ayuda para realizar esta actividad |

4.21 |

.920 |

4.34 |

.914 |

4.05 |

.908 |

|

Considero que aplicaré esta prueba en mi futuro laboral |

3.92 |

1.053 |

3.76 |

1.047 |

4.10 |

1.038 |

|

Considero que esta práctica ha sido de ayuda para mi aprendizaje |

4.34 |

.754 |

4.44 |

.649 |

4.23 |

.848 |

|

Considero necesaria la existencia de una guía de evaluación que me ayude a conocer los procesos de evaluación |

4.24 |

.791 |

4.23 |

.772 |

4.26 |

.816 |

|

Me han explicado previamente cómo se corregía la prueba y lo he entendido con claridad |

4.04 |

1.007 |

4.28 |

.974 |

3.77 |

.977 |

Fuente: elaboración propia.

A continuación, se señalan las dificultades encontradas por orden descendente. Se observa que la “dificultad para escuchar/entender lo que se dice en el vídeo” se puntúa como mayor dificultad; seguida de: “dificultad de observar de manera visual los resultados que se tenían que obtener”; “dificultad para obtener unas conclusiones de la prueba/protocolo/registro que nos aporte información de los problemas de los participantes”, “dificultad para escribir el informe basándome en los resultados de la prueba”, “dificultad para escribir en la hoja de registro los resultados ofrecidos” y, por último, “dificultad para obtener la baremación”.

Tabla 3. Resultados de las pruebas de Kolmogorov-Smirnov y de U de Mann-Whitney del grupo que ha utilizado las pruebas estandarizadas y las baterías y del grupo que ha utilizado los protocolos y registros

|

Kolmogorov-Smirnov |

U de Mann-Whitney |

||||

|

Test, registro o prueba |

Estadístico |

Sig. |

Valor |

Z |

Sig. |

|

Dificultad para escuchar/entender lo que se decía en el vídeo |

.217 |

.000 |

3049.50 |

-4.948 |

.000 |

|

Dificultad para observar de manera visual los resultados que se tenían que obtener |

.168 |

.000 |

4936.00 |

-.116 |

.908 |

|

Dificultad para escribir en la hoja de registro los resultados ofrecidos |

.211 |

.000 |

3326.00 |

-4.268 |

.000 |

|

Dificultad para obtener la baremación. |

.242 |

.000 |

3538.00 |

-3.739 |

.000 |

|

Dificultad para obtener unas conclusiones de la prueba/protocolo/registro que nos aporte información de los problemas de los participantes |

.223 |

.000 |

3834.00 |

-2.941 |

.003 |

|

Dificultad para escribir el informe basándome en los resultados de la prueba |

.199 |

.000 |

3710.50 |

-3.245 |

.001 |

|

Esta práctica es adecuada en esta asignatura |

.377 |

.000 |

4323.500 |

-1.894 |

.058 |

|

Los conocimientos que poseía eran suficientes para realizar esta práctica |

.228 |

.000 |

3532.00 |

-3.722 |

.000 |

|

Me he sentido cómodo/a con la práctica |

.229 |

.000 |

2022.50 |

-7.581 |

.000 |

|

Esta prueba/protocolo/registro es difícil de aplicar |

.244 |

.000 |

3969.00 |

-2.583 |

.010 |

|

La labor del profesor ha sido de gran ayuda para realizar esta actividad |

.281 |

.000 |

3979.50 |

-2.650 |

.008 |

|

Considero que aplicaré esta prueba en mi futuro laboral |

.235 |

.000 |

3991.00 |

-2.552 |

.011 |

|

Considero que esta práctica ha sido de ayuda para mi aprendizaje |

.297 |

.000 |

4813.00 |

-1.529 |

.126 |

|

Considero necesaria la existencia de una guía de evaluación que me ayude a conocer los procesos de evaluación |

.257 |

.000 |

3402.00 |

-.450 |

.653 |

|

Me han explicado previamente cómo se corregía la prueba y lo he entendido con claridad |

.250 |

.000 |

3991.00 |

-4.098 |

.000 |

Fuente: elaboración propia.

En relación a la dimensión adecuación de la práctica, se puede observar que las mejor valoradas son: “esta práctica es adecuada en esta asignatura”; “considero que esta práctica ha sido de gran ayuda para mi aprendizaje” y “considero necesaria la existencia de una guía de evaluación que ayude a conocer los procesos de evaluación”; mientras que, “esta prueba/protocolo/registro es difícil de aplicar”; tiene un resultado cercano a 2.5; lo que significa que tienen una dificultad media para aplicar las pruebas. Para determinar si las diferencias entre ambos grupos son significativas se han empleado otras pruebas estadísticas (Tabla 3).

En la Tabla 3 se muestran los resultados de Kolmogorov-Smirnov y U de Mann-Whitney. Los resultados de Sig. de Kolmogorov-Smirnov son < 0.05, indicando diferencias en la distribución de las variables analizadas. Por lo tanto, se utilizan pruebas no paramétricas, como U de Mann-Whitney, para determinar si hay diferencias en las medianas de las variables entre los grupos. Cuatro variables tienen un resultado de Sig. de U de Mann-Whitney > 0.05, lo cual indica que no hay diferencias en las medianas de esas variables, mientras que en el resto es < 0.05, indicando que sí hay diferencias en las medianas de las variables.

Del análisis cualitativo se obtuvieron las dificultades encontradas por los estudiantes, solamente un 68.5% de los estudiantes han escrito algo en este apartado; todas las citas se codificaron como “dificultades”. Ante la pregunta a los estudiantes sobre si hubieran cambiado algo en la práctica, el 63% respondió que no, mientras que el 37% respondió afirmativamente. Todas las respuestas afirmativas se codificaron como “propuestas de cambio”.

Figura 1. Red de códigos de las dificultades y propuestas de cambio ofrecidas por los estudiantes. Fuente: elaboración propia.

En la Figura 1 se muestra el enraizamiento (E), que es la cantidad de citas enlazadas al código, y la densidad (D) de cada código, que indica el número de códigos asociados a una cita: de esta manera se puede analizar cómo están interrelacionados todos los códigos. Un ejemplo de esto es que las citas que están asociadas al código “dificultades” (D=5), también están asociadas con otros 5 códigos: “carga de trabajo”, “corrección e interpretación de las pruebas”, “audio y/o imagen del vídeo”, “conocimiento previo” y “explicación de la prueba”. En la Figura 1 se observa que algunos códigos están asociados con “es causa de” con el código “dificultades”. Si nos fijamos en estos códigos, podemos observar que hay un mayor número de citas del código “audio y/o imagen del vídeo” (E=85) y de “corrección e interpretación de las pruebas” (E=66); que del código “explicación de la prueba” (E=6). A continuación, se presentan algunos ejemplos:

• “Ha sido demasiado trabajo, la transcripción no tendríamos por qué haberla hecho nosotras, nos la podía haber dado hecha la profesora.” (Fragmento 1 del cuestionario, codificado con “dificultades” y “carga de trabajo”).

• “He tenido dificultades a la hora de corregir la prueba porque no sabía cómo funcionaban los percentiles junto con la edad.” (Fragmento 2 del cuestionario, codificado con “dificultades” y “corrección e interpretación de las pruebas”).

• “En ocasiones, el audio del vídeo se distorsionaba o se oían las respuestas del paciente de forma clara.” (Fragmento 3 del cuestionario, codificado con “dificultades” y “audio y/o imagen del vídeo”).

• “En algunas ocasiones he tenido ciertas dudas por la falta de conocimiento personal ya que no lo había hecho antes.” (Fragmento 4 del cuestionario, codificado con “dificultades” y “conocimiento previo”).

• “La profesora nos explicó cómo se corregía la prueba correctamente, pero me parece insuficiente dedicar solo una clase presencial a explicar la prueba.” (Fragmento 5 del cuestionario, codificado con “dificultades” y “explicación de la prueba”).

Las citas que están asociadas al código “propuesta de cambio” (D=4) también están asociadas con otros 4 códigos: “carga de trabajo”; “corrección e interpretación de las pruebas”; “presenciales” “audio y/o imagen del vídeo”. Lo que indica que hay propuestas de cambio relacionadas con esos cuatro códigos. Todos ellos tienen una densidad de 2, a excepción de “presencialidad” que tiene una densidad de 1 ya que solo está asociado con “propuestas de cambio” y el resto con “propuestas de cambio” y “dificultades”. El código de “presencialidad” es el que menor enraizamiento tiene (E=3); el resto de los códigos tiene un enraizamiento mucho mayor. A continuación, se presenta un ejemplo de cada una de ellas:

• “Sí, la verdad que hubiese cambiado tan solo una cosa, con el vídeo hubiese facilitado ya una plantilla con lo que decían, una escritura normal, sin signos ni nada, ya que hemos tardado mucho y haría más breve el trabajo a la hora de transcribirlo.” (Fragmento 6 del cuestionario, codificado con “propuesta de cambio” y “carga de trabajo”).

• “Cambiaría la manera en la que se ha realizado la interpretación de los resultados, creo que es necesario dar un ejemplo de informe para ver qué es lo que tenemos que realizar, ya que es la primera vez que lo hemos hecho.” (Fragmento 7 del cuestionario, codificado con “propuesta de cambio” y “corrección e interpretación de las pruebas”).

• “Lo hubiera realizado a un niño de manera presencial, para hacernos a la situación de cómo tratar con un niño pasando una prueba.” (Fragmento 8 del cuestionario, codificado con “propuesta de cambio” y “presenciales”).

• “Hubiera cambiado la calidad del audio del vídeo, se escuchaba a veces como tosía la logopeda, y algunos ruidos.” (Fragmento 9 del cuestionario, codificado con “propuesta del cambio” y “audio y/o imagen del vídeo”).

Por último, el código de “aspectos beneficiosos” tiene una densidad de 0, como se puede ver en la gráfica, ya que sus citas no están asociadas a ningún otro código. Se observa que existen 19 citas asociadas al código (E=19), algunos ejemplos son:

• “Esta práctica es la que más me ha gustado durante todo el curso, hemos podido ver cómo vamos a trabajar luego.” (Fragmento 10 del cuestionario, codificado con “aspectos beneficiosos”).

• “No cambiaría nada, me ha encantado, nos acerca a lo que vamos a hacer luego, y he podido ver cómo se hace con una persona de verdad.” (Fragmento 11 del cuestionario, codificado con “aspectos beneficiosos”).

En resumen, es conveniente destacar que los resultados revelan una serie de dificultades encontradas por los estudiantes en la aplicación y corrección de pruebas de evaluación del lenguaje oral, destacando la dificultad para escuchar y entender lo que se decía en los vídeos, así como para observar visualmente los resultados esperados. Además, se identificaron obstáculos en la obtención de conclusiones significativas de las pruebas y en la redacción de informes basados en los resultados. El análisis cualitativo reveló que algunas de estas dificultades estaban relacionadas con la carga de trabajo, la corrección e interpretación de las pruebas, así como con problemas técnicos en la transcripción de los vídeos. Sin embargo, los estudiantes también expresaron propuestas de cambio, como la facilitación de plantillas para transcripciones, ejemplos de informes y la realización de prácticas presenciales con niños. Además, se observó una apreciación positiva general hacia la utilidad de la práctica en el aprendizaje, destacando su capacidad para proporcionar una visión concreta del trabajo futuro y su valor como experiencia enriquecedora.

4. Discusión

Una vez expuestos los resultados obtenidos sobre la satisfacción y las dificultades encontradas por los estudiantes de los grados en Logopedia y Maestro en Educación Primaria en torno al proyecto formativo, a continuación, se plantean y contrastan con las evidencias científicas para finalizar con el planteamiento de las conclusiones.

Hay evidencias de que el desempeño docente y las estrategias de aprendizaje del alumnado inciden significativamente en la satisfacción académica de los estudiantes, al igual que existe una relación directa entre la satisfacción de los estudiantes cuando realizan las actividades didácticas con el éxito académico en esa asignatura (De Oca-Serpa et al., 2023; Guzmán, 2011), por ello es tan importante conocer la satisfacción de los estudiantes en los procesos formativos. Además, según Garza (2017), los estudiantes tienen la necesidad de que el docente proporcione vídeos que ilustren sus explicaciones y les ayuden en su formación. En este sentido, los resultados de este estudio han determinado que la satisfacción de los estudiantes en cuanto a estas actividades es bastante alta, y ellos mismos valoran de manera positiva que se les acerque su futura realidad laboral al aula a través de vídeos. Esto se puede observar en los resultados de las preguntas sobre adecuación de las prácticas (todos ellos superior a 4) y en las respuestas codificadas como “aspectos beneficiosos” de las preguntas cualitativas.

Tras los resultados obtenidos, dada la dificultad media (puntuación cercana a 2.5) obtenida en la aplicación de este tipo de pruebas, se puede concluir que los estudiantes ven la necesidad de tener a su disposición guías de evaluación que ayuden a conocer los procesos de evaluación. En este sentido, existe una guía con similar temática, pero centrada en el lenguaje oral (Ayuso-Lanchares et al. 2022), que les facilita la aplicación y comprensión de este tipo de pruebas. Ellos mismos, como futuros logopedas y maestros, opinan que aplicarán esta prueba en su futuro laboral (puntuación alta de 3.92); en este sentido, Prego-Vázquez y Varela (2023) afirman que los centros educativos acogen alumnado con una gran diversidad de capacidades y habilidades lingüísticas diferentes por lo que es necesario conocer la existencia de esas diferencias individuales que puedan afectar a su aprendizaje.

En esta investigación se ha diferenciado entre la enseñanza de pruebas estandarizadas/baterías y la enseñanza de protocolos/registros, pero no se han encontrado diferencias entre ambos grupos en las siguientes variables: (1) la dificultad para observar de manera visual los resultados que se tenían que obtener, lo que quiere decir que la dificultad era la misma independientemente de si la enseñanza era de un tipo de prueba u otro; (2) consideran que la práctica es adecuada a las asignaturas para los dos tipos de pruebas; (3) creen que estas prácticas son de ayuda para aprender sobre los dos tipos de pruebas; (4) y también piensan que es necesaria y útil una guía de evaluación del lenguaje oral para las dos pruebas.

Por el contrario, sí se encuentran diferencias significativas en: la dificultad para escuchar/entender lo que se decía en el vídeo; en la dificultad para escribir en la hoja de registro los datos; en la dificultad para obtener unas conclusiones y en la redacción del informe. El grupo que aplicó pruebas estandarizadas y baterías tuvo más apuros que el grupo que aplicó los protocolos y registros. Esto puede ser porque los protocolos y registros siguen unas normas cerradas, mientras que las pruebas estandarizadas y las baterías disponen de una baremación y parte de las respuestas son cerradas (Ayuso-Lanchares et al. 2022); y obviamente, es más fácil entender un audio cuando se sabe que la respuesta es cerrada; y de la misma manera, es más sencillo obtener unas conclusiones y redactar un informe cuando el manual de la prueba explica paso a paso cómo realizarlo.

Además, sorprendentemente, los estudiantes que han aplicado las pruebas estandarizadas y baterías opinan que tienen más conocimientos para realizar esta práctica que los que han aplicado los protocolos y registros. Se desconoce el motivo de este hallazgo y puede ser una posible línea de investigación futura. También hallamos esta diferencia significativa en la pregunta sobre si consideran que aplicarán esta prueba en su futuro laboral; así que, muchos de ellos opinan que utilizarán en su futuro laboral con más frecuencia las pruebas estandarizadas que los protocolos y registros.

En definitiva, los resultados de esta investigación presentan varias implicaciones para la enseñanza y el aprendizaje de la aplicación de pruebas de lenguaje oral. Por un lado, los docentes pueden conocer un proyecto formativo que ya se ha llevado a cabo, recogiendo ideas para poner en práctica el suyo propio; y, por otro lado, pueden aprender sobre la satisfacción de los estudiantes y sus dificultades encontradas al realizarlo, lo que puede ser de gran utilidad para mejorar la calidad de los procesos de enseñanza (Craig et al., 2008). Aun así, obviamente, hay que tomar estos datos con cautela, teniendo en cuenta que se requiere aumentar la muestra y las titulaciones implicadas. En este sentido, se pretende continuar trabajando en esta línea con el fin de mejorar los procesos de formación universitaria.

Referencias

Adrián, J.A., Jorquera, J. y Cuetos, F. (2015). NEUROBEL: Breve batería neuropsicológica de evaluación del lenguaje oral en adultos-mayores. Datos normativos iniciales. Revista de Logopedia, Foniatría y Audiología 35, 101-113. https://doi.org/10.1016/j.rlfa.2014.12.004

Aguado, G. (1989). El desarrollo de la morfosintaxis en el niño. Manual de Evaluación del T.S.A., CEPE.

Aguinaga, G., López de Suso, M L., Fraile Blázquez, A., Olangua Baquedano, P. y Uriz, N. (2004). PLON-R. Prueba del Lenguaje Oral de Navarra – Revisada, TEA Ediciones.

Álvarez-Pérez, P. R., López-Aguilar, D. y Pérez-Jorge, D. (٢٠١٥). El alumnado universitario y la planificación de su proyecto formativo y profesional. Actualidades investigativas en educación, 15(1), 395-419.

Amirrudin, M., Nasution, K. & Supahar, S. (2021). Effect of variability on Cronbach alpha reliability in research practice [Efecto de la variabilidad en la fiabilidad de alfa de Cronbach en la práctica de investigación.]. Jurnal Matematika, Statistika dan Komputasi, 17(2), 223-230.

Ayuso-Lanchares, A., Santiago-Pardo, R. B. y Ruíz-Requies, I. (2022). Introducción. En A. Ayuso-Lanchares y R. B. Santiago-Pardo (Eds.) Guía de Evaluación del Lenguaje Oral. libro (pp. 11-18). Editorial Universidad de Valladolid

Bosch, L. (1983). El desarrollo fonológico infantil: una prueba para su evaluación. Anuario de Psicología, 28, 85-114.

Calleja-Reina, M., Santos, J. M. R., Liñán, M. L. L. y Urbano, J. F. (2019). LATS (Language Assessment Training system) una propuesta b-learning para adquirir competencias en toma de decisiones clínicas en intervención logopédica. Revista Eduser, 6(2), 85-93.

Carballo, G. (2012). Guía para la evaluación del TEL: algunas consideraciones. Revista de Logopedia, Foniatría y Audiología, 32(2), 87-93. https://doi.org/10.1016/j.rlfa.2012.03.004

Cicchetti, D. V. & Sparrow, S. A. (1981). Developing criteria for establishing interrater reliability of specific items: applications to assessment of adaptive behavior [Desarrollo de criterios para establecer la confiabilidad entre evaluadores de ítems específicos: aplicaciones para la evaluación del comportamiento adaptativo.]. American Journal of Mental Deficiency, 86(2), 127–137.

Cifuentes-Lardín, M. S. & Martínez-Ramón, J. P. (2018). Diseño de un instrumento para el análisis de las competencias del logopeda escolar y del maestro de Audición y Lenguaje. European Journal of Child Development, Education and Psychopathology, 6(1), 47-56. https://doi.org/10.30552/ejpad.v6i1.61

Cohen, N. J. (2001). Language impairment and psychopathology in infants, children, and adolescents [Deterioro del lenguaje y psicopatología en infantes, niños y adolescentes]. Sage Publications.

Craig, C. J., Ross, V., Conle, C. & Richardson, V. (2008). Cultivating the image of teachers as curriculum makers [Cultivando la imagen de los profesores como creadores de currículo.] In F.M. Connelly, M. Fang He, & J. Phillion. The Sage handbook of curriculum and instruction (pp. 282-305). Sage Publications Inc.

Creswell, J.W. (2014). Research design: qualitative, quantitative, and mixed methods approaches. Sage.Thousand Oaks.

De Oca-Serpa, J. H. M., Ramírez, A. B., y Tirado, J. (2023). Estrategias de aprendizaje y desempeño docente en la satisfacción académica en universitarios de Lima. Propósitos y Representaciones, 11(2), e1792-e1792. https://doi.org/10.20511/pyr2023.v11n2.1792

Dunn, L. M., Dunn, L. M. & Arribas, D. (2006). Peabody, test de vocabulario en imágenes. TEA ediciones.

Fernández-Urquiza, M., Díaz Martínez, F., Moreno Campos, V., Lázaro López-Villaseñor, M. y Simón López, T. (2015). Protocolo rápido de evaluación pragmática-Revisado. Universidad de Valencia. https://go.oei.int/o05molvj

Flick, U. (2018). Introducción a la investigación cualitativa. Morata.

García-Gómez, T., Vázquez-Recio, R. y Calvo-García, G. (2022). Las políticas educativas para la equidad en la formación del profesorado. Archivos Analíticos de Políticas Educativas, 30(119). https://doi.org/10.14507/epaa.30.6883

Garza, J. F. (2017). Análisis de las reproducciones de vídeos en un canal educativo en YouTube. Memorias del Encuentro Internacional de Educación a Distancia, 5(5), 1-19.

Guetterman, T. C. & Fetters, M. D. (2018). Two methodological approaches to the integration of mixed methods and case study designs: A systematic review. American Behavioral Scientist, 62(7), 900-918. https://doi.org/10.1177/0002764218772641

Guzmán, J. C. (2011). La calidad de la enseñanza en educación superior ¿Qué es una buena enseñanza en este nivel educativo? Perfiles Educativos, 33, 129-141.

Greene, J. C. (2007). Mixed Methods in Social Inquiry. Jossey-Bass.

Juárez, A. y Monfort, M. (1996). Registro fonológico inducido. CEPE.

Kirk, S. A., McCarthy, J. J. & Kirk, W. D. (2004). Test Illinois de aptitudes psicolingüísticas ITPA. Adaptación española. TEA.

Law, J., McKean, C., Murphy, C. A. & Thordardottir, E. (2019). Managing Children with Developmental Language Disorder [Manejo de niños con Trastorno del Lenguaje del Desarrollo.]. Routledge.

Ley 44/2003, de 21 de noviembre de 2003, de ordenación de las profesiones sanitarias. Boletín Oficial Del Estado, núm. ٢٨٠, pp. ٤١٤٤٢-٤١٤٥٨. https://go.oei.int/egisdrfy

Ley Orgánica 3/2020, de 29 de diciembre, por la que se modifica la Ley Orgánica 2/2006, de 3 de mayo, de Educación. Boletín Oficial del Estafo, núm. 340, miércoles 30 de diciembre de 2020, pp. 122868- 122953. https://go.oei.int/cgsumye5

Mendoza, E. (2010). La evaluación del lenguaje: orientaciones alternativas. Revista de Logopedia, Foniatría y Audiología, 30(4), 167-173. https://doi.org/10.1016/S0214-4603(10)70152-2

Mendoza, E., Carballo, G., Muñoz, J. y Fresneda, M. D. CEG. (2005). Test de Comprensión de Estructuras Gramaticales. E.T.E.

Modrego-Alarcón, M., Crespo-Alacreu, A., Miro-Sanz, A., Martinez-Lietos, A. B., Aznar-Soro, B., Haro-Castilla, B., Faci-Jimenez, B., Dito-Lahuerta, E., Vicente-Sánchez, E., Eguinoa-Zaborras, F. Álvarez-Jiménez, I., Manzano-Gonzalez, J. R., Anadón-Ginés, L., Garrido-Laparte, M. A., Martinez-Arnanz, M. A., Vazquez-Porta, M. I., Ferrandez-Pardos, M. P... y Blanco-Romanos, V. M. (2022). Tendiendo puentes entre el profesorado universitario de la mención de audición y lenguaje del departamento de psicología y sociología y el profesorado especialista de los centros educativos. Universidad de Zaragoza.

Morales-Ocaña, A. y Higueras-Rodríguez, M. L. (2017). Procesos de enseñanza-aprendizaje. Estudios y experiencias. Profesorado, Revista de Currículum y Formación Del Profesorado, 21(2), 1-6.

Nieva, S., Bartuilli, M., González, P. A., Melle, N., Murillo, E., Pareja, A., ... y Schüller, M. T. (2015). Técnicas de evaluación e intervención en Logopedia: base de datos audiovisual de la Unidad Clínica de Logopedia. https://go.oei.int/wffev2kd.

Peñalba-Acitores, A., García-Atarés, N., Jimeno-Bulnes, N. y Santiago-Pardo, R. B. (2014). Desarrollo de competencias del docente universitario a través del programa intensivo internacional de logopedia. Aula de encuentro, 16(1), 35-52.

Pérez-Serrano, G. (1994). Investigación cualitativa. Retos, interrogantes y métodos. La Muralla.

Prego-Vázquez, G. & Varela, Z. (2023). Superdiversidad lingüística en los nuevos contextos multilingües: una mirada etnográfica y multidisciplinar. Iberoamericana. Vervuert

Raposo-Rivas, M., Fuentes Abeledo, E. J. y González Sanmamed, M. (2006). Desarrollo de competencias tecnológicas en la formación inicial de maestros. RELATEC: Revista Latinoamericana de Tecnología Educativa,5(2), 525-537. https://go.oei.int/rayxh5kp.

Real Decreto 861/2010, de 2 de julio, que modifica el Real Decreto 1393/2007, de 29 de octubre, por el que se establece la ordenación de las enseñanzas universitarias oficiales. Boletín Oficial del Estado, 3 de julio de 2010, núm. 161, pp. 58545-58468. https://www.boe.es/eli/es/rd/2010/07/02/861

Reeves, T.D. & Honig, S.L. (2015). A classroom data literacy intervention for preservice teachers. Teaching and Teacher Education, 50, 90-101. http://dx.doi.org/10.1016/j.tate.2015.05.007

Schoch, K. (2020). Case study research [Investigación de estudio de caso]. In J, B De Gary, A. Kimberley, L. Crawford & J. Hirchcok (Editor). Research design and methods: An applied guide for the scholar-practitioner, (pp. 245-258).

Sevillano-García, M. L. y Fuero-Colmena, R. (2013). Formación inicial del profesorado en TICS: Un análisis de Castilla la Mancha. Profesorado. Revista de Currículum y Formación de Profesorado, 17(3), 151-183.

Simons, H. (2011). El estudio de caso: Teoría y práctica. Ediciones Morata.

Tirapu-Ustárroz, J. (2007). La evaluación neuropsicológica. Psychosocial Intervention, 16(2), 189-211.

Vallés, A. (1990). Evaluación de la dislalia: prueba de articulación de fonemas. CEPE.

Wirz, S. (1993). Historical consideration in assessment [Consideraciones históricas en la evaluación.] En J. R. Beech, L. Harding y D. Hilton-Jones (eds.), Assessment in Speech and Language Therapy. Routledge.